空桶

我們從最簡單的限流配置開始:

limit_req_zone?$binary_remote_addr?zone=ip_limit:10m?rate=10r/s; server?{ ??location?/login/?{ ????limit_req?zone=ip_limit; ????proxy_pass?http://login_upstream; ??} }

-

$binary_remote_addr 針對客戶端ip限流;

-

zone=ip_limit:10m 限流規則名稱為ip_limit,允許使用10mb的內存空間來記錄ip對應的限流狀態;

-

rate=10r/s 限流速度為每秒10次請求

-

location /login/ 對登錄進行限流

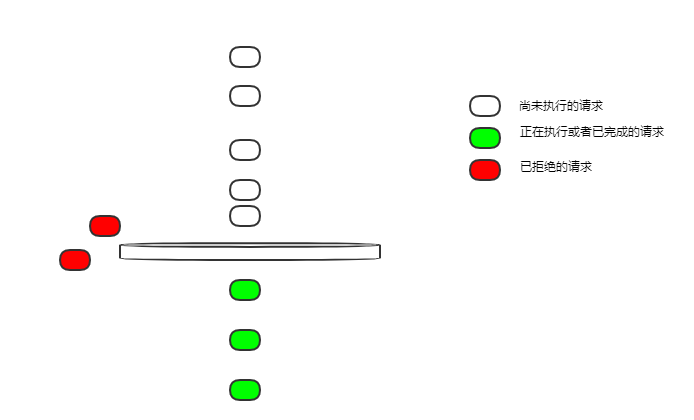

限流速度為每秒10次請求,如果有10次請求同時到達一個空閑的nginx,他們都能得到執行嗎?

漏桶漏出請求是勻速的。10r/s是怎樣勻速的呢?每100ms漏出一個請求。

在這樣的配置下,桶是空的,所有不能實時漏出的請求,都會被拒絕掉。

所以如果10次請求同時到達,那么只有一個請求能夠得到執行,其它的,都會被拒絕。

這不太友好,大部分業務場景下我們希望這10個請求都能得到執行。

burst

我們把配置改一下,解決上一節的問題

limit_req_zone?$binary_remote_addr?zone=ip_limit:10m?rate=10r/s; server?{ ??location?/login/?{ ????limit_req?zone=ip_limit?burst=12; ????proxy_pass?http://login_upstream; ??} }

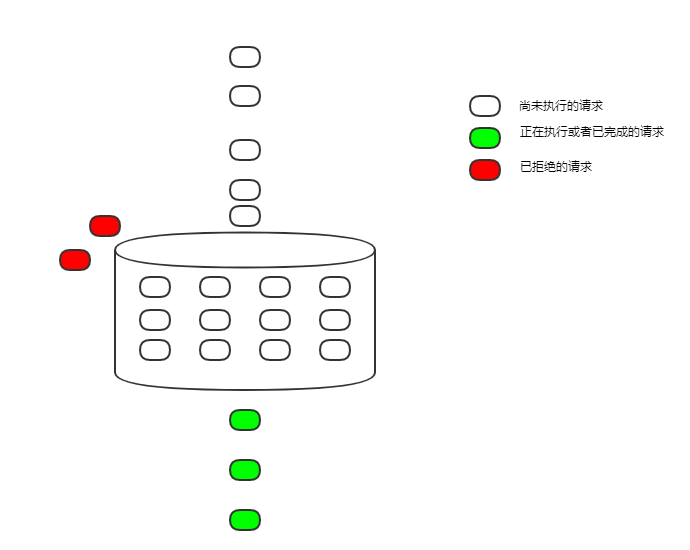

burst=12 漏桶的大小設置為12

邏輯上叫漏桶,實現起來是fifo隊列,把得不到執行的請求暫時緩存起來。

這樣漏出的速度仍然是100ms一個請求,但并發而來,暫時得不到執行的請求,可以先緩存起來。只有當隊列滿了的時候,才會拒絕接受新請求。

這樣漏桶在限流的同時,也起到了削峰填谷的作用。

在這樣的配置下,如果有10次請求同時到達,它們會依次執行,每100ms執行1個。

雖然得到執行了,但因為排隊執行,延遲大大增加,在很多場景下仍然是不能接受的。

nodelay

繼續修改配置,解決delay太久導致延遲增加的問題

limit_req_zone?$binary_remote_addr?zone=ip_limit:10m?rate=10r/s; server?{ ??location?/login/?{ ????limit_req?zone=ip_limit?burst=12?nodelay; ????proxy_pass?http://login_upstream; ??} }

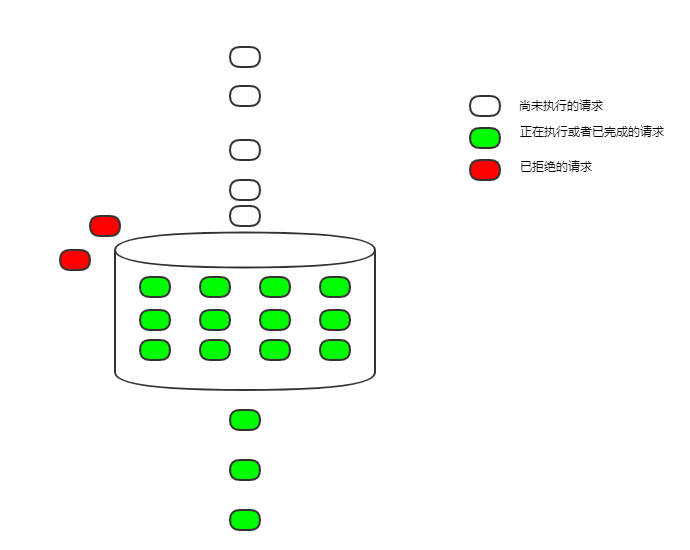

nodelay 把開始執行請求的時間提前,以前是delay到從桶里漏出來才執行,現在不delay了,只要入桶就開始執行

要么立刻執行,要么被拒絕,請求不會因為限流而增加延遲了。

因為請求從桶里漏出來還是勻速的,桶的空間又是固定的,最終平均下來,還是每秒執行了5次請求,限流的目的還是達到了。

但這樣也有缺點,限流是限了,但是限得不那么勻速。以上面的配置舉例,如果有12個請求同時到達,那么這12個請求都能夠立刻執行,然后后面的請求只能勻速進桶,100ms執行1個。如果有一段時間沒有請求,桶空了,那么又可能出現并發的12個請求一起執行。

大部分情況下,這種限流不勻速,不算是大問題。不過nginx也提供了一個參數才控制并發執行也就是nodelay的請求的數量。

limit_req_zone?$binary_remote_addr?zone=ip_limit:10m?rate=10r/s; server?{ ??location?/login/?{ ????limit_req?zone=ip_limit?burst=12?delay=4; ????proxy_pass?http://login_upstream; ??} }

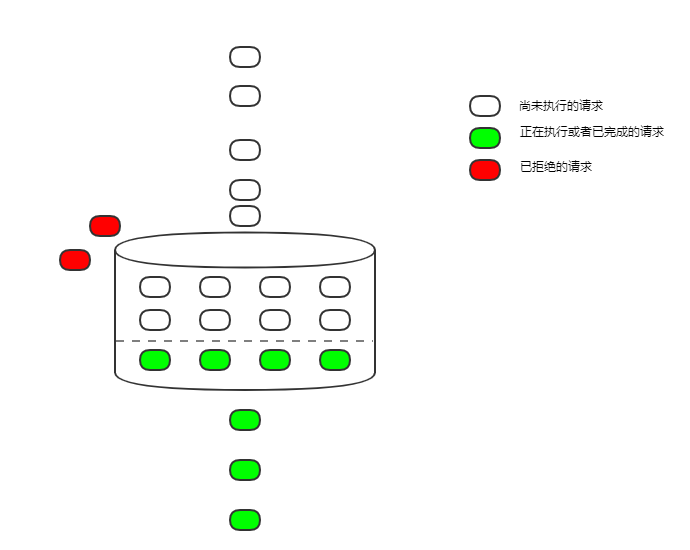

delay=4 從桶內第5個請求開始delay

這樣通過控制delay參數的值,可以調整允許并發執行的請求的數量,使得請求變的均勻起來,在有些耗資源的服務上控制這個數量,還是有必要的。